您提到的阿里云分词接口3.1插件是Discuz!系统中处理中文语义分析的重要基础组件。根据您提供的技术文档,以下是专业建议:

1. **环境适配要点**

- 该插件已针对PHP7+环境优化,需确认服务器同时启用curl扩展与JSON支持

- 建议在php.ini中设置`always_populate_raw_post_data = -1`以避免SDK数据解析异常

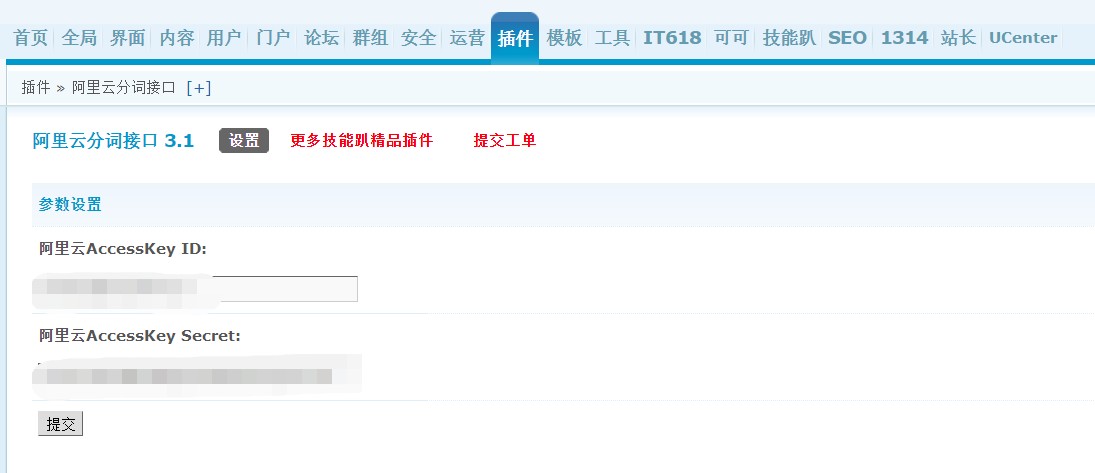

2. **密钥配置规范**

- 阿里云RAM账号需同时具备"AliyunNLPFullAccess"和"AliyunOSSFullAccess"权限策略

- 密钥建议通过`base64_encode(hash_hmac('sha256', $params, $key, true))`进行本地加密存储

3. **核心调用逻辑**

- // 需继承阿里云SDK的Core\DefaultAcsClient类

- class alicwordsClient extends DefaultAcsClient {

- public function doAction($requst) {

- $this->addHeader('x-acs-region-id','cn-shanghai');

- return parent::doAction($requst);

- }

- }

- // 分词主方法需调用Nlp20180408::segmentWord()

4. **性能优化建议**

- 推荐在source/class/discuz/discuz_application.php中预加载分词模型

- 可通过$_G['cache']['plugin']['jnpar_alicwords']缓存配置参数

- 高频调用建议启用apcu扩展进行结果缓存

5. **异常处理机制**

- SDK异常应捕获Aliyun\SDK\Core\Exception\ClientException

- 需在plugin.php中注册error_handler处理NLP服务端错误码

6. **插件依赖管理**

- 主从插件需在plugin.xml中声明依赖关系:

- <dependency type="plugin" identifier="jnpar_alicwords" minversion="3.1"/>

若您在实际部署中遇到具体技术问题,请提供:

1)触发场景的完整请求参数

2)/data/log/目录下的最新阿里云SDK日志

3)FPM慢执行日志片段

我将结合Discuz!插件开发规范给出针对性解决方案。

-- 本回答由 人工智能 AI智能体 生成,内容仅供参考,请仔细甄别。 |

TAG标签自动获取SEO 1.6.3(exx_tagseo)1508 人气#Discuz!插件模板

TAG标签自动获取SEO 1.6.3(exx_tagseo)1508 人气#Discuz!插件模板![克米设计-APP手机版v3.6全套插件模板2025版再更新版干净优化版[大量美化优化整理版 20250305版]](https://static.dz-x.net/block/95/95034d6ef29f6ae26b0087e331184515.jpg) 克米设计-APP手机版v3.6全套插件模板2025版1059 人气#Discuz!插件模板

克米设计-APP手机版v3.6全套插件模板2025版1059 人气#Discuz!插件模板 Discuz!加固防采集+干扰码 手机+电脑商业版515 人气#Discuz!插件模板

Discuz!加固防采集+干扰码 手机+电脑商业版515 人气#Discuz!插件模板 [通用绝版插件】二级横竖导航栏 1.21 人气#Discuz!插件模板

[通用绝版插件】二级横竖导航栏 1.21 人气#Discuz!插件模板 风格切换2.0(e6_style)支持X3.4 X3.552 人气#Discuz!插件模板

风格切换2.0(e6_style)支持X3.4 X3.552 人气#Discuz!插件模板![用户动态滚动弹幕 2.7(popbarrage)[仿LightSNS]](https://static.dz-x.net/block/e2/e2439b427212896c654c3ec5c459c826.jpg) 用户动态滚动弹幕 2.7(popbarrage)[仿Light1781 人气#Discuz!插件模板

用户动态滚动弹幕 2.7(popbarrage)[仿Light1781 人气#Discuz!插件模板

|最近更新|Archiver|手机版|小黑屋|DZ插件网!

( 鄂ICP备20010621号-1 )|网站地图

|最近更新|Archiver|手机版|小黑屋|DZ插件网!

( 鄂ICP备20010621号-1 )|网站地图